Update 4 maart 2021: Google heeft inmiddels zelf ook een uitgebreide uitlegvideo op YouTube geplaatst. Deze vind je aan het einde van dit artikel.

Op 24 november 2020 lanceerde Google eindelijk haar langverwachte nieuwe crawlstatistieken rapport in Google Search Console. Google heeft het rapport geüpdatet, zodat website-eigenaren beter begrijpen hoe Googlebots hun website lezen. Sinds de komst van de vernieuwde Google Search Console in januari 2018 was dit namelijk een van de weinige rapporten die de oude interface nog gebruikte. Maar welke nieuwe functies zijn er nu beschikbaar? Wat betekent dit voor SEO en waar moet je op letten? Je leest het allemaal in dit artikel!

Het rapport vind je terug onder Instellingen:

Welke nieuwe functies heeft het nieuwe crawlstatistieken rapport?

Het nieuwe rapport heeft de volgende nieuwe functies:

- Je kunt het totaal aantal verzoeken groeperen op:

Response Code: 404, 301, 302 etc. Je ziet hier voornamelijk de status 200 code. Maak je geen zorgen over de 404’s, want die zijn er altijd. Sterker nog: volgens Google’s John Mueller geeft het feit dat mensen 404’s lezen aan dat er crawlbudget over is dat aan niet (meer) bestaande pagina’s besteed kan worden.

Gecrawld bestandstype: HTML, Javascript, afbeelding etc. Als je website trage response-percentages ziet, kijk je in deze tabel om erachter te komen welke bronnen Google crawlt en waarom dit de crawl mogelijk vertraagt. Misschien leest Google wel te veel kleine afbeeldingen die je beter kan blokkeren.

Crawldoel: bestaande pagina’s vernieuwen of nieuwe pagina’s ontdekken. In de meeste gevallen is vernieuwen het grootste deel van het crawldoel. Het crawldoel vindbaarheid is alleen groter als je bijvoorbeeld een nieuwe site lanceert, er een sitemigratie plaatsvindt of als je een nieuwe sitemap uploadt.

Googlebot-type: smartphone, desktop, afbeelding etc. Het merendeel van je crawlverzoeken moet van je primaire crawler (smartphone of desktop) afkomstig zijn. Als je crawlpieken hebt, controleer dan het type user-agent.

Welke nieuwe functies zie je nog meer in het nieuwe crawlrapport:

- Je ziet een gedetailleerde status van de host (als Google bijvoorbeeld moeite heeft met het lezen van je website):

- Voorbeelden van pagina’s, om te laten zien waar in je website de Googlebots zijn geweest

- Uitgebreide samenvatting voor properties, met meerdere hosts en ondersteuning voor domein-properties

In vergelijking met het oude crawlstatistieken rapport is er dus veel veranderd.

In het oude rapport was er alleen een onderverdeling in het aantal pagina’s dat per dag gecrawld werd, het aantal gedownloade kilobytes en hoeveel tijd bezoekers op een pagina doorbrachten.

Het nieuwe crawlstatistieken rapport is duidelijk veel gedetailleerder en geeft precies weer welke pagina’s er gecrawld worden en hoe bezoekers je website waarderen.

Voor wie is dit belangrijk?

Het crawlstatistieken rapport is voornamelijk bedoeld voor de gevorderde SEO’er of webhost. Als jouw website niet meer dan 1000 pagina’s heeft, dan hoor je dit rapport eigenlijk niet nodig te hebben. In dat geval hoef jij je dan ook geen zorgen te maken om op dit niveau een crawl-analyse te maken.

Waarom is dit belangrijk?

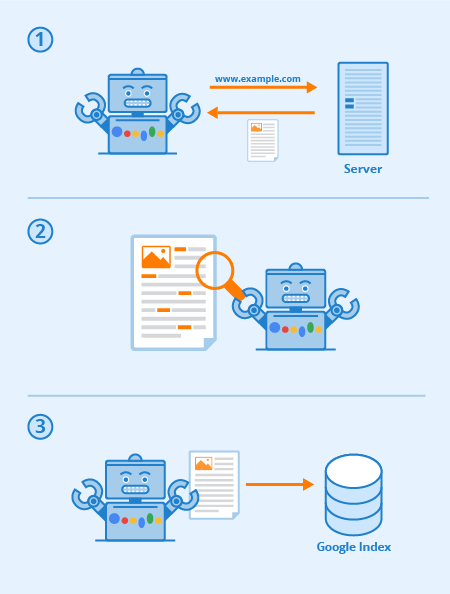

Crawl-budget heeft alles te maken met hoe zoekmachines jouw website lezen, begrijpen en in hun index (de zoekresultatenpagina’s) laten zien. Hoe beter de zoekmachine jouw website begrijpt, hoe hoger je positie in de zoekresultaten is.

Wat betekenen de crawlstatistieken voor SEO?

Het crawl-budget is dus erg belangrijk voor SEO, maar hoe wordt dat budget nu precies gevormd?

- Crawlers gebruiken links op websites om andere pagina’s te ontdekken. Daarom is een goede interne linkstructuur erg belangrijk

- Crawlers geven voorrang aan nieuwe websites, aanpassingen aan bestaande websites en dode links

- Een geautomatiseerd proces bepaalt welke websites er gecrawld worden en hoe vaak en hoeveel pagina’s van elke site getoond moeten worden.

Omdat het internet uit ontzettend veel pagina’s bestaat, is dit een erg ingewikkeld en duur proces voor zoekmachines. Om dit proces zo efficiënt en effectief mogelijk te maken, geven zoekmachines voorrang aan pagina’s en paginabronnen.

Het crawl-budget is het aantal pagina’s van een website dat een crawler van plan is te bezoeken in een bepaalde tijd. Zodra dit ‘budget’ op is, stopt de crawler je website te lezen en gaat verder met een andere website.

Wat is nu vervelender dan dat de crawler je belangrijkste of nieuwste pagina’s op je website overslaat? Juist! Voorkom daarom dat de zoekmachine jouw belangrijkste pagina’s niet of zelfs de verkeerde pagina’s crawlt. Als er veel crawlfouten op je website voorkomen, betekent dat in de ogen van een zoekmachine eigenlijk dat jij je website niet goed onderhoudt. Daarom geeft de zoekmachine je pagina’s een lagere ranking in de zoekresultaten.

Waar moet je onder andere op letten?

Let erop dat in het nieuwe crawlstatistieken rapport bijvoorbeeld geen serverfouten (5xx) voorkomen of dat het robots.txt-bestand niet ingevuld is. Die laatste is een van de meest gemaakte SEO-fouten.

Worden er veel 404’s gecrawld? Dat is op zich geen probleem, maar na bijvoorbeeld een websitemigratie betekent dit dat er iets mis is gegaan met redirects.

Het nieuwe crawlrapport geeft je gedetailleerde informatie over hoe Google jouw website leest en begrijpt, op een niveau dat met het oude rapport simpelweg niet mogelijk is.

Vraag jij je nu af of jouw website op de juiste manier gecrawld wordt? Of wil je meer weten over het nieuwe crawlstatistieken rapport? Whello staat klaar om je vragen te beantwoorden.

Neem gerust contact op met een van onze SEO specialisten. Bekijk hier al onze zoekmachine marketing diensten.

Google’s eigen uitleg over het vernieuwde crawl statistieken rapport: